多层神经网络遭遇寒冬

相关报告

- 数据更新中...

多层神经网络难以训练,相关研究受到冷落。尽管在早期神经网络一般最多也就做到2到3个隐层,但却已经遇到了当时几乎无法解决的过拟合、局部最优、梯度扩散等问题。算法本身面临的解决能力瓶颈,导致神经网络逐渐陷入寒冬。

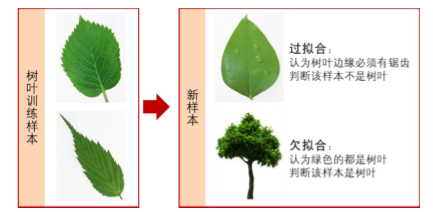

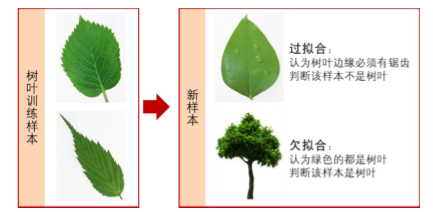

①、欠拟合/过拟合问题。如果可用来训练的数据量不够,或者在神经网络中节点(神经元)过少,

学习效果就会比较粗糙,无法很好地表达样本数据的规律,称之为“欠拟合”;而如果隐层节点太多,一方面由于计算能力限制会导致学习训练所需要的时间过长,另一方面会使得训练得到的模型

泛化能力很差,仅能对训练数据集中的实例进行判断,无法处理未遇到过的案例,这种“过犹不及”的情形称之为“过拟合”。

图6:

以“树叶分类”为例看“过拟合”与“欠拟合”

以“树叶分类”为例看“过拟合”与“欠拟合”

②、局部最优问题。后来人们选择增加隐层的数量,利用每一层相对少一些的神经元数量来拟合更

加复杂的函数。但是,随着神经网络层数的加深,越来越容易陷入局部最优难以自拔从而导致找不

到全局最优。在训练神经网络寻找最优参数时常用的方法是寻找使得整体误差最小的方案,一般从

随机选定的一个初始位置出发,按照一定规则在其周围寻找使得误差变小到不能再小的点。但传统做法一旦陷入到如图所示的局部最优以后就会停止搜索,于是也就错过了全局最优的点。

随着层数增加,神经网络容易陷入局部最优

③、梯度扩散问题。另一个问题则是层数的增加导致在训练过程出现停滞、训练效果变差,在专业

术语中称之为“梯度扩散”。在训练神经网络时,一般都会将误差从靠近输出端的神经元向靠近输入端的神经元传递(即BP误差反向传播算法),通过不断迭代寻找使得误差最小的参数(前面提

过的权值、阈值等),但所使用的方法在多层神经网络中不稳定,经常在误差传播到中间某一层时罢工不再起作用,甚至会出现层数增加反而训练效果变差的情形。

本文地址:http://www.zwzyzx.com/show-336-224858-1.html

上一篇:神经网络发展几经波折

下一篇:深度学习正式面世并持续发展

相关资讯

- 全球卫星导航定位系统竞争格局(2014-05-21)

- 北京年平均网购金额全国最高(2013-12-05)

- Oculus不在中国首发(2016-08-24)

- 国内印刷线路板行业总体技术水平仍存在差距(2014-12-12)

- 苦练养功,确保关键信息基础设施癿自主安全可控(2016-09-21)

- 军工行业具有显著的国产化特征要求我国提高信息化自我研发实力(2014-05-29)

- 目前宽带接入技术的市场份额(2015-04-12)

- 光模块在数据宽带、电信通讯领域已经有广泛的应用(2014-06-26)

合作媒体

最新报告

定制出版

热门报告

免责声明

中为咨询所引述的资料是用于行业市场研究以及讨论和交流,并注明出处,部分内容是由相关机构提供。若有异议请及时联系本公司,我们将立即依据相关法律对文章进行删除或作相应处理。查看详细》》