AI芯片发展助力人工智能腾飞

相关报告

- 2015-2020年中国芯片行业市场深度调查分析及投资战略研究报告(2015-03-24)

- 2014-2018年中国控制IC行业市场深度剖析及投资前景趋势研究报告(2014-09-09)

- 2014-2018年中国智能终端芯片行业市场深度剖析及投资前景趋势研究报告(2014-09-21)

- 2016-2022年中国微处理器芯片区域行业市场调查研究及发展分析报告(2015-11-13)

- 2016-2022年中国LED芯片区域行业市场调查研究及发展分析报告(2015-11-13)

- 全国主要地区发光二极管芯片产业发展状况暨投资环境调查研究报告(2014-12-02)

- 2015-2020年中国固定电话芯片行业市场主要领域调查分析报告(2015-09-15)

- 2016-2022年中国半导体芯片行业市场深度调查研究及投资咨询报告(2015-12-10)

- 2015-2020年中国半导体芯片行业市场深度剖析及投资前景趋势研究报告(2015-03-24)

- 2015-2020年中国数字信号处理芯片行业市场主要领域调查分析报告(2015-09-16)

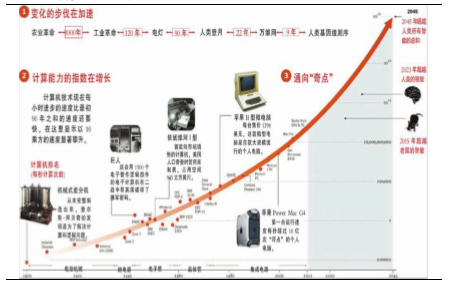

计算技术的不断发展。深度学习等机器学习算法需要用大量的数据进行训练,而传统的数据处理技术难以满足高强度大数据处理的需求。近些年来,由于计算机运算能力的快速提高,尤其是GPU在大规模并行计算中的应用,使得深层的神经网络训练效率大幅提升,极大地推动了人工智能的发展。

芯片性能的不断提高。最新一代微处理器的性能是1971年第一代单片机的400万倍。过去,先进的系统设计只能在理论上成立但无法实现,因为它所需要的计算机资源过于昂贵或者计算机无法胜任;今天,我们已经可以以较低的成本获得计算资源,同时大规模的集中式计算也已基本实现。

计算性能的发展

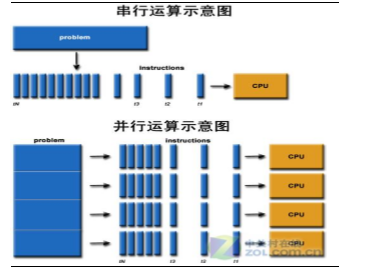

并行计算大幅度提升机器学习的效率。人的思维过程是一个并行过程,数以亿计的神经元同时放电才能创造出大脑皮层用于计算的同步脑电波,搭建一个神经网络也需要许多不同的进程同时运行。如计算机要理解某个口语单词,需要能够听清不同音节彼此之间的所有音素;要识别出某幅图片,需要看到其周围像素环境内的所有像素—二者都是深层次的并行任务。

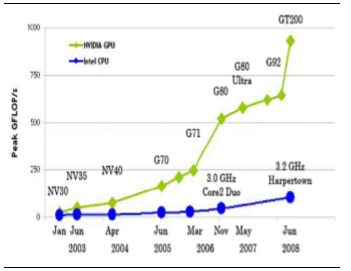

GPU的应用使大规模并行计算得以实现。GPU是专为执行复杂的数学和几何计算而设计的数据处理芯片,将更多的晶体管用作执行单元,而不是像CPU那样用作复杂的控制单元和缓存,因此具有更加强悍的计算能力。以目前的桌面式计算机为例:现在主流的i7处理器的浮点计算能力仅仅是是主流的英伟达GPU处理器浮点计算能力的1/12。

GPU和CPU浮点运算能力对比

并行计算和串行计算示意图

研究报告新型计算技术的发展将大幅度提高人工智能效率。目前主流的计算机微处理器普遍采用冯〃诺依曼结构,受到半导体物理技术的限制,微处理器运算速度的提高已经趋于缓慢,基于多核处理器或者集群计算机的并行计算技术已经逐渐成为提高计算机运算性能的主要手段,但并行计算设备中的微处理器同样受冯〃诺依曼瓶颈的制约,所以在处理一些数据密集型,如图像分析等问题时,计算速度和性价比不理想。目前在深度学习计算领域GPU的性能要优于CPU,但也未必一定会是未来的发展道路,目前,各大科研机构和芯片厂商都在探索AI芯片的发展方向,如FPGA和神经元芯片等。

现场可编程门阵列(FPGA):可以直接下载用户现场设计的数字电路,行业研究芯片中的每个逻辑门在每个时钟周期都同时进行着某种逻辑运算,非常适合用于开发并行计算应用。日渐流行的FPGA设计工具使其对深度学习领域经常使用的上层软件兼容性更强,使得FPGA更容易为模型搭建和部署者所用。FPGA架构灵活,使得研究者能够在诸如GPU的固定架构之外进行模型优化探究。同时,FPGA在单位能耗下性能更强。目前,FPGA已被成功地应用到分子动力学、基因组测序、神经网路、图像处理、机器博弈等领域,取得了不错的应用效果。

神经元芯片:一种模拟人脑神经元结构的芯片。这种芯片把数字处理器当作神经元,把内存作为突触,跟传统冯〃诺依曼结构不一样,它的内存、CPU和通信部件是完全集成在一起,因此信息的处理完全在本地进行。而且由于本地处理的数据量并不大,传统计算机内存与CPU之间的瓶颈不复存在。

现场可编程门阵列(FPGA):可以直接下载用户现场设计的数字电路,行业研究芯片中的每个逻辑门在每个时钟周期都同时进行着某种逻辑运算,非常适合用于开发并行计算应用。日渐流行的FPGA设计工具使其对深度学习领域经常使用的上层软件兼容性更强,使得FPGA更容易为模型搭建和部署者所用。FPGA架构灵活,使得研究者能够在诸如GPU的固定架构之外进行模型优化探究。同时,FPGA在单位能耗下性能更强。目前,FPGA已被成功地应用到分子动力学、基因组测序、神经网路、图像处理、机器博弈等领域,取得了不错的应用效果。

神经元芯片:一种模拟人脑神经元结构的芯片。这种芯片把数字处理器当作神经元,把内存作为突触,跟传统冯〃诺依曼结构不一样,它的内存、CPU和通信部件是完全集成在一起,因此信息的处理完全在本地进行。而且由于本地处理的数据量并不大,传统计算机内存与CPU之间的瓶颈不复存在。

AI-PU未来或像GPU一样成为计算机的标配。想要发挥专用芯片的计算效率优势需要芯片结构和软件算法两者相匹配。由于对计算机图像处理需求的不断增强,长于并行计算的GPU应运而生,成为了计算机标配的部件之一,随着未来对计算机人工智能应用需求的不断增强,专门用于加速人工智能应用的AI-PU或将成为计算机另一个标配的组件。

FPGA芯片概念图

IBM神经元芯片

本文地址:http://www.zwzyzx.com/show-336-245799-1.html

上一篇:AI芯片发展助力人工智能腾飞

下一篇:人工智能产业链

相关资讯

- 工业过程无线监测市场应用发展情况(2016-01-25)

- 程序化购买市场规模(2016-09-05)

- 烽火通信:骨干网SDN解决方案提供商,白盒交换机供应商(2016-08-12)

- 防水引领声学大升级,结构材料重设计提升价值(2016-10-12)

- 移动终端设备与上、下游行业之间的关联性(2016-03-04)

- 我国运营商CDN平台软件市场规模(2014-06-07)

- 晶闸管是我国功率半导体分立器件中技术成熟的细分产品(2015-05-25)

- 通信网络管理服务行业对营销服务网点要求较高(2014-06-30)

合作媒体

最新报告

定制出版

热门报告

免责声明

中为咨询所引述的资料是用于行业市场研究以及讨论和交流,并注明出处,部分内容是由相关机构提供。若有异议请及时联系本公司,我们将立即依据相关法律对文章进行删除或作相应处理。查看详细》》